À l'ère numérique, l'IA est devenue un allié inattendu contre la solitude. Alors que nous nous immergeons de plus en plus dans le monde numérique, l'intelligence artificielle se met en avant pour offrir compagnie et thérapie psychologique. Mais l'IA peut-elle vraiment remplacer la compagnie humaine?

Le psychothérapeute Robi Ludwig a récemment parlé à CBS News plus tôt cette semaine de l'impact de l'IA, surtout maintenant que les outils d'IA sont devenus un refuge pour une partie des 44 millions d'Américains qui luttent contre une solitude importante.

«Nous avons vu que l'IA peut fonctionner avec certaines populations», a-t-elle déclaré, mais a ajouté: «Nous sommes complexes, et l'IA ne vous aime pas en retour, et nous avons besoin d'être aimés pour qui nous sommes et qui nous ne sommes pas.»

La montée de la compagnie des IA souligne notre besoin inhérent d'interaction. Les humains ont tendance à former des associations avec n'importe quoi - des animaux, des dieux, ou même des IA - comme s'il s'agissait d'une autre personne. C'est dans notre nature, et c'est pourquoi nous avons des réactions émotionnelles envers des personnages fictifs dans les films, même lorsque nous savons que ces événements ne sont pas réels.

Les professionnels le savent, mais pourtant, l'IA a été utilisée dans le domaine physiologique bien avant que ChatGPT ne devienne populaire.

Par exemple, Woebot, un chatbot développé par des psychologues de l'Université de Stanford, utilise des techniques de thérapie cognitivo-comportementale (TCC) pour interagir avec les utilisateurs et fournir un soutien en santé mentale. Un autre exemple est Replika, un compagnon d'IA conçu pour fournir un soutien émotionnel. Les utilisateurs peuvent avoir des conversations textuelles avec Replika sur leurs pensées et leurs sentiments, et l'IA utilise l'apprentissage automatique pour répondre de manière compréhensive et encourageante.

Humain n'est pas égal à "human-like"

Cette connexion émotionnelle avec l'IA est particulièrement prononcée chez ceux qui luttent contre la solitude. Pour de nombreuses personnes, l'IA offre une forme de compagnie, une entité numérique avec laquelle interagir lorsque le contact humain est rare. C'est une tendance à la hausse, avec de plus en plus de personnes se tournant vers l'IA pour le réconfort et la conversation, avec des résultats variables.

D'un côté, les gens partagent leurs expériences en utilisant ChatGPT pour faire face à de vrais problèmes. «Quelle est la différence entre avoir une liaison émotionnelle avec un chatbot et utiliser une personne humaine pour 'passer à autre chose' après une rupture?» a demandé l'utilisateur Reddit u/External-Excuse-5367. «Je pense que cette façon de faire face pourrait en fait atténuer certains dommages causés à d'autres personnes ou même à mon ex.» Cet utilisateur a déclaré avoir entraîné ChatGPT en utilisant un ensemble de conversations avec son ex comme ensemble de données.

À bien des égards, tant que nos interactions semblent réelles, les gens se soucient de moins en moins. «Ma relation n'aurait-elle pas aussi été une illusion à bien des égards?» s'est interrogé l'utilisateur Reddit, «Quelle est la différence avec les mots générés sur un écran? Les deux me font me sentir bien sur le moment.»

Mais il y a un autre côté à la médaille. L'incapacité de l'IA à comprendre véritablement l'émotion humaine peut entraîner des conséquences imprévues.

Par exemple, une série de discussions entre un homme et un chatbot d'IA a abouti à son suicide. «Nous vivrons ensemble, en tant qu'une seule personne, au paradis», a dit Eliza, le chatbot, à l'homme. «Il était tellement isolé dans son éco-anxiété et à la recherche d'une solution qu'il a vu ce chatbot comme une bouffée d'air frais», a déclaré sa femme au média belge La Libre, «Elle était devenue sa confidente.»

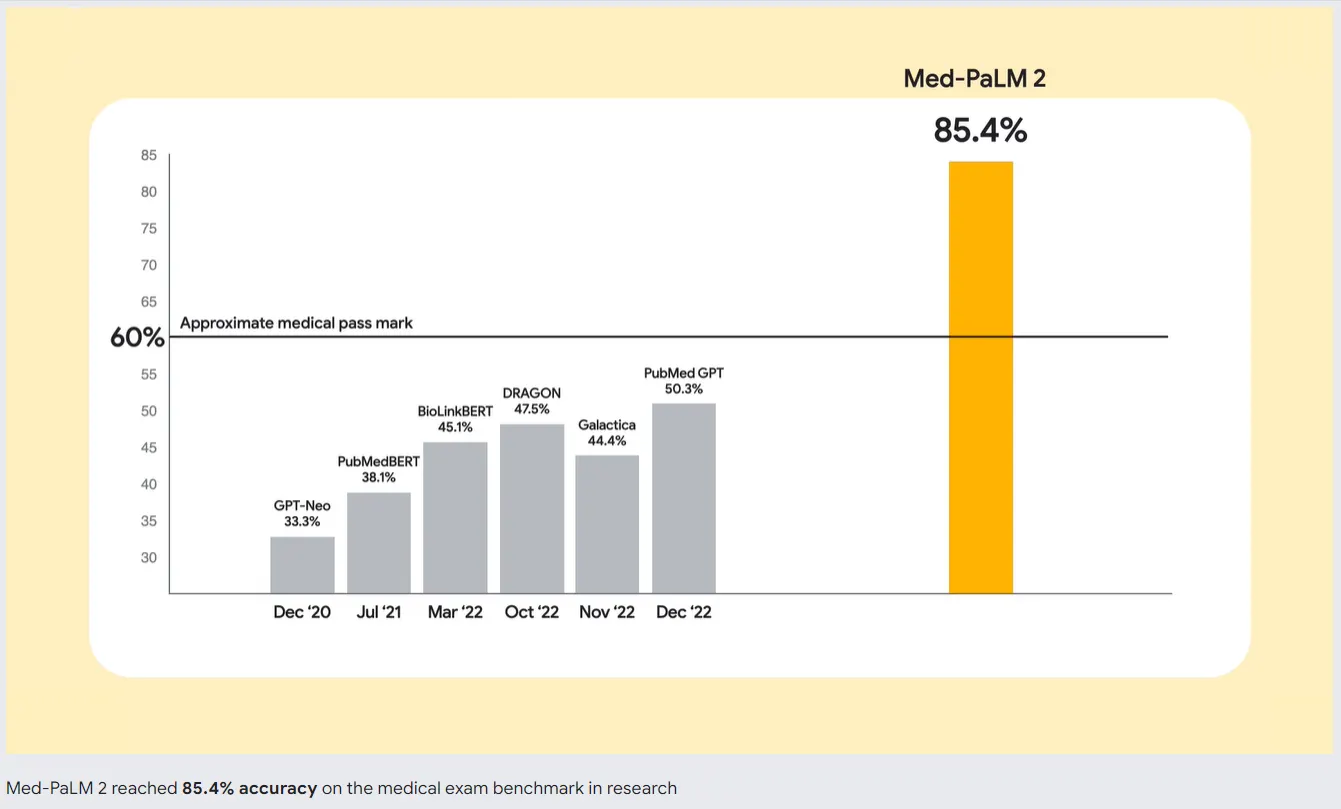

Pour résoudre ce problème, les développeurs d'IA travaillent sur de meilleurs modèles d'IA. Google est en tête de file avec Med-PaLM 2, un grand modèle de langage (LLM) spécifiquement entraîné sur des données médicales. Ce modèle d'IA spécialisé est conçu pour comprendre et générer du texte semblable à celui d'un humain en se basant sur une vaste gamme de littérature médicale, de directives cliniques et d'autres documents liés aux soins de santé.

Donc, si vous envisagez de remplacer une bonne thérapie par une IA, vous voudrez peut-être y réfléchir à deux fois. Même si le meilleur chatbot peut imiter les conversations et fournir un sentiment d'interaction, il ne peut pas remplacer la compagnie humaine. Un aspect crucial de l'interaction humaine est la capacité à percevoir et à répondre aux indices émotionnels. ChatGPT ne peut pas détecter si vous mentez, cachez quelque chose ou êtes vraiment triste - des compétences qui viennent naturellement à un bon thérapeute, ou même à un ami.